Met ChatGPT of Copilot kun je gebruik maken van erg krachtige AI-assistenten dankzij de onderliggende large language models. Nadeel is dat bij de gratis versie je gesprekken gebruikt worden voor trainingsdoeleinden. Wil je wat meer privacy? Dan kan het een goede optie zijn om een large language model lokaal te draaien. Wij laten zien hoe je dat voor elkaar krijgt met Ollama.

Een ‘large language model’ is een term in de AI voor een model dat getraind is op heel erg veel tekst. Op die manier kan de LLM tekst genereren en dienen als AI-assistent. Er komen steeds meer large language models beschikbaar. ChatGPT is natuurlijk erg populair en maakt veel voortgang met nieuwe modellen zoals GPT 4o en o1. Maar ook Meta, Anthropic en Google werken aan hun eigen LLM’s en dus aan hun eigen AI-assistenten.

Een aantal van deze modellen kun je lokaal draaien, hetzij in afgeslankte vorm. Op die manier blijft alle data die je erin zet privé en heb je geen last van vertragingen als de servers het te druk krijgen. Ook kun je een onbeperkte hoeveelheid vragen stellen, in tegenstelling tot de limieten van online diensten.

Voordat je aan de slag gaat, is het wel nodig dat je pc ten minste 8 GB aan intern geheugen heeft. Daarmee kun je de kleinree modellen lokaal draaien. Als je ook de iets grotere modellen wilt draaien, dan heb je ten minste 16 GB nodig.

Ollama installeren en gebruiken

In deze howto gebruiken we Ollama, waarmee je de keuze hebt uit AI-modellen van onder andere Google, Meta en Microsoft. Je kunt Ollama op de website downloaden voor Windows, macOS of Linux. Wij gaan aan de slag met Windows. Klik op de downloadknop in het midden van de website en klik daarna op Download for Windows (Preview). Voer het gedownloade bestand uit om de installatie te starten. Klik op Install om de installatie te starten.

De installatie sluit zich vanzelf af en vervolgens start Ollama in de achtergrond. Klik op de Windows-notificatie rechtsonder met de tekst Click here to get started om aan de slag te gaan met Ollama. Er opent dan een opdrachtprompt waarbij dan instructies staan om een model te installeren. Heb je de notificatie gemist of gebeurt er niets, geen zorgen. Klik dan met de rechtermuisknop op de Windows-knop en kies voor Terminal of Opdrachtprompt.

Om een LLM te installeren, typ je ollama run <modelnaam>. Als je bijvoorbeeld Llama 3.1 van Meta wilt gebruiken, typ dan ollama run llama3.1. Ollama gaat dan aan de slag om het model te downloaden en te installeren en vervolgens kun je met de LLM chatten, net zoals je dat met ChatGPT of Copilot zou doen. Wel gebeurt het chatten vanuit de terminal.

Het downloaden van het model kan enige tijd in beslag nemen. Llama 3.1 is bijvoorbeeld 4,7 GB groot. Na het downloaden kun je direct beginnen met chatten. Typ een bericht en druk op Enter om het te versturen.

Als je een nieuwe chat wilt starten, typ je /clear. Wil je je sessie opslaan, typ dan /save <naam>. Je kunt dan op een later moment je gesprek weer terughalen en doorgaan met de chat. Door /load <naam> te typen. Typ /bye om Ollama te beeindigen en /? voor een overzicht van alle beschikbare commando’s.

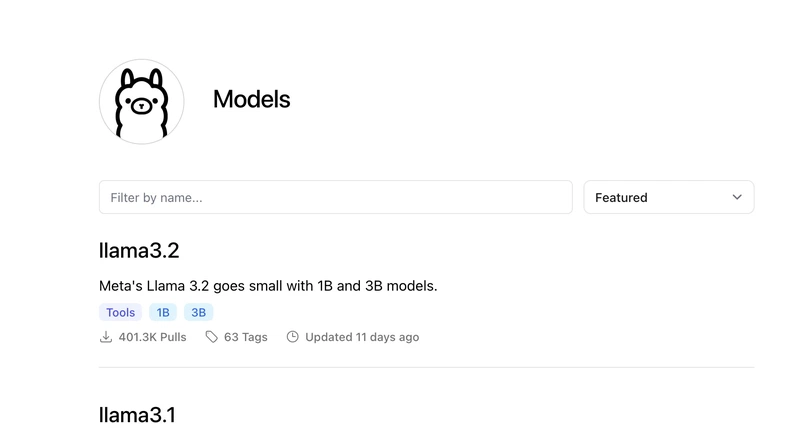

Naast Llama 3.1 zijn er nog andere modellen beschikbaar in Ollama. Zo kun je Gemma gebruiken van Google, Qwen van Alibaba, Phi van Microsoft en Nemotron van Nvidia. Je vindt het volledige overzicht van alle beschikbare modellen op de website van Ollama. Om een model te gebruiken, typ je in een terminal ollama run <modelnaam>. Als je toch weer een model wilt verwijderen om ruimte vrij te maken, typ dan ollama rm <modelnaam>. Typ ollama list om alle geinstalleerde LLM’s te zien.

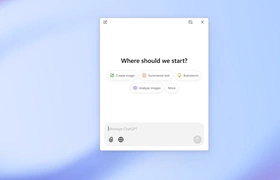

Ollama met afbeeldingen

Soms wil je ook afbeeldingen kunnen invoeren in je LLM. Dat kan ook met Ollama. Daarvoor is het als eerste nodig om een model te gebruiken dat overweg kan met afbeeldingen. Je kunt daarvoor llava gebruiken. Open een terminal en typ: ollama run llava:7b. Wacht even terwijl het model gedownload wordt, dat is 4,1 GB groot. Overigens staat de 7b voor de modelgrootte, in dit geval 7 miljard parameters. Hoe meer parameters, hoe ‘slimmer’ het model. Je kunt ook Llava downloaden met 13 miljard parameters of 34 miljard parameters, maar dan groeit het model naar respectievelijk 7,4 GB of 19 GB.

Na het downloaden, kun je een afbeelding invoeren met het volgende commando: ollama run llava en voer dan in describe this image: C:/Users/

Conclusie

In deze howto hebben we je laten zien hoe je Ollama installeert en er daarna mee aan de slag te gaat. Ook hebben we je laten zien welke commando’s je kunt gebruiken voor je chats, hoe je andere LLM’s kunt installeren en gebruiken en hebben we je laten zien hoe je afbeeldingen kunt gebruiken met Ollama.